Vivimos en tiempos increíbles, hasta podría decirse que son mágicos, pero nos acostumbramos a que sea así y ya no nos damos cuenta.

Uno puede comprar un lápiz por menos de Gs. 500 (unos 6 centavos de dólar), sin embargo, NADIE, ninguno de los 8 mil millones de humanos puede construir ese lápiz por si solo. En ese humilde lápiz están la mina de grafito, arcilla y grasa ensamblados en la proporción adecuada moldeados en un cilindro de 2 mm de diámetro, las 2 mitades de madera pulida que sostienen la mina, la cola para unir las mitades, el metal que sostiene la goma, el caucho usado en la goma de borrar, la pintura del exterior, las cuchillas para el afilado de la punta, el montado de todas las partes y todo lo que implica el empaquetado, sin contar todo lo necesario para que cada una de las partes llegue a la fábrica, y luego de construido, el producto terminado llegue tus manos, a través de una compleja cadena que involucra vehículos terrestres, marítimos, tal vez incluso aéreos, de varios tamaños y formas, contenedores, grúas, canales interoceánicos, ríos dragados artificialmente para hacerlos navegables, depósitos, tiendas de venta y ni qué decir la cadena de pagos donde el dinero con el que pagaste el lápiz en el punto de venta, se junta con otros, para que luego vayan a un banco, donde el depósito queda como un registro en una base de datos, hasta que algo o alguien envíe una orden que le indica al banco que descuente un valor determinado, debitando ese monto y acreditándolo en otro banco de otro país en otra moneda, para que finalmente, vuelva a haber un débito de ese segundo banco y un crédito en un tercer banco posiblemente en una tercera moneda; sin contar con los procesos de conciliación entre todas esas operaciones financieras, ni los procesos contables administrativos e impositivos, ni las probablemente miles de personas que de alguna manera u otra estuvieron involucradas.

Parece que ya nada nos sorprende. Tal vez por desconocimiento, tal vez por falta de interés, o tal vez porque ya es rutina. La magia nos rodea, pero ya no la percibimos.

Ya normalizamos que hoy uno simplemente pueda decir en voz alta, «OK Google, ¿cómo va a estar el tiempo mañana?» y a los pocos segundos tengamos una respuesta.

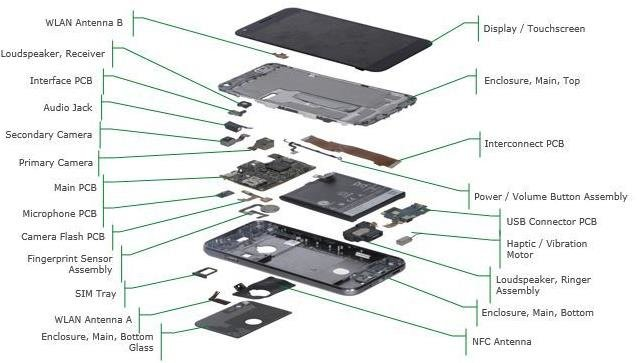

A nadie parece maravillar lo que ocurre en esos segundos: mi voz mueve moléculas de aire cercanas, que a su vez empujan otras moléculas de aire y así por delante, como ondas en un lago, hasta que unos milisegundos después llegan a la membrana del micrófono en el smartphone que también comienza a vibrar y a su vez activa un circuito eléctrico generando una minúscula corriente eléctrica que es convertida en pulsos eléctricos para que puedan ser manipulados más fácilmente de manera digital.

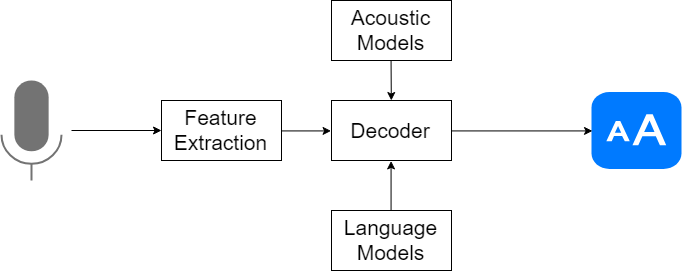

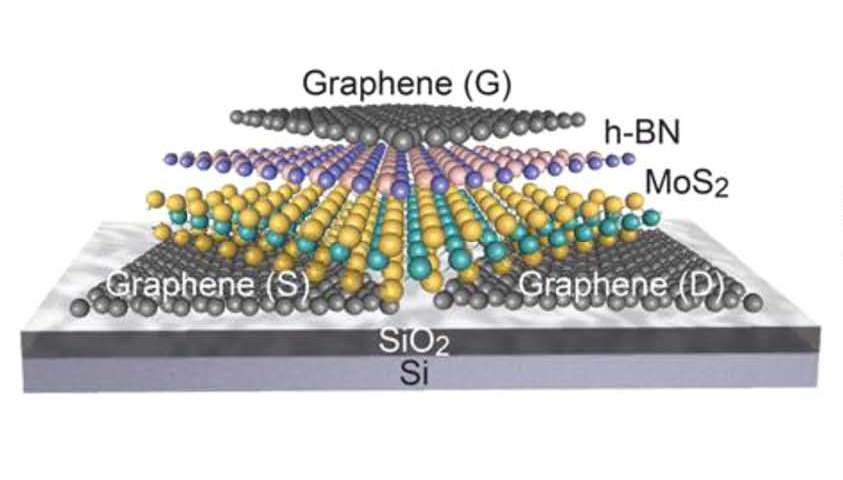

La llegada de estos pulsos eléctricos dispara un frenesí de actividad eléctrica en el circuito del teléfono, controlado por varias capas de software, cada una con una función específica. Los pulsos eléctricos ya convertidos en código binario (bits) se almacenan en la memoria del celular, alterando el estado de minúsculos transistores del tamaño de moléculas de ADN aplicando fuerzas eléctricas para atraer o repeler electrones según fuera necesario. En algún momento, la información binaria (unos y ceros) llega al programa responsable de controlar las acciones siguientes de qué hacer con el hilo de unos y ceros. Usando fórmulas matemáticas complejas traducidas a rutinas de software, el programa responsable determina que una secuencia de la cadena de bits se acerca con un porcentaje relativamente alto de probabilidad al patrón matemático de la frase disparadora «OK Google», indicando que debe “escuchar” el resto de la secuencia de bits para convertirlos en “palabras clave” de manera a tratar de interpretar la “intención” de la frase, para luego tomar una acción que puede implicar comunicarse con servidores en la nube para su procesamiento y eventualmente obtener una respuesta.

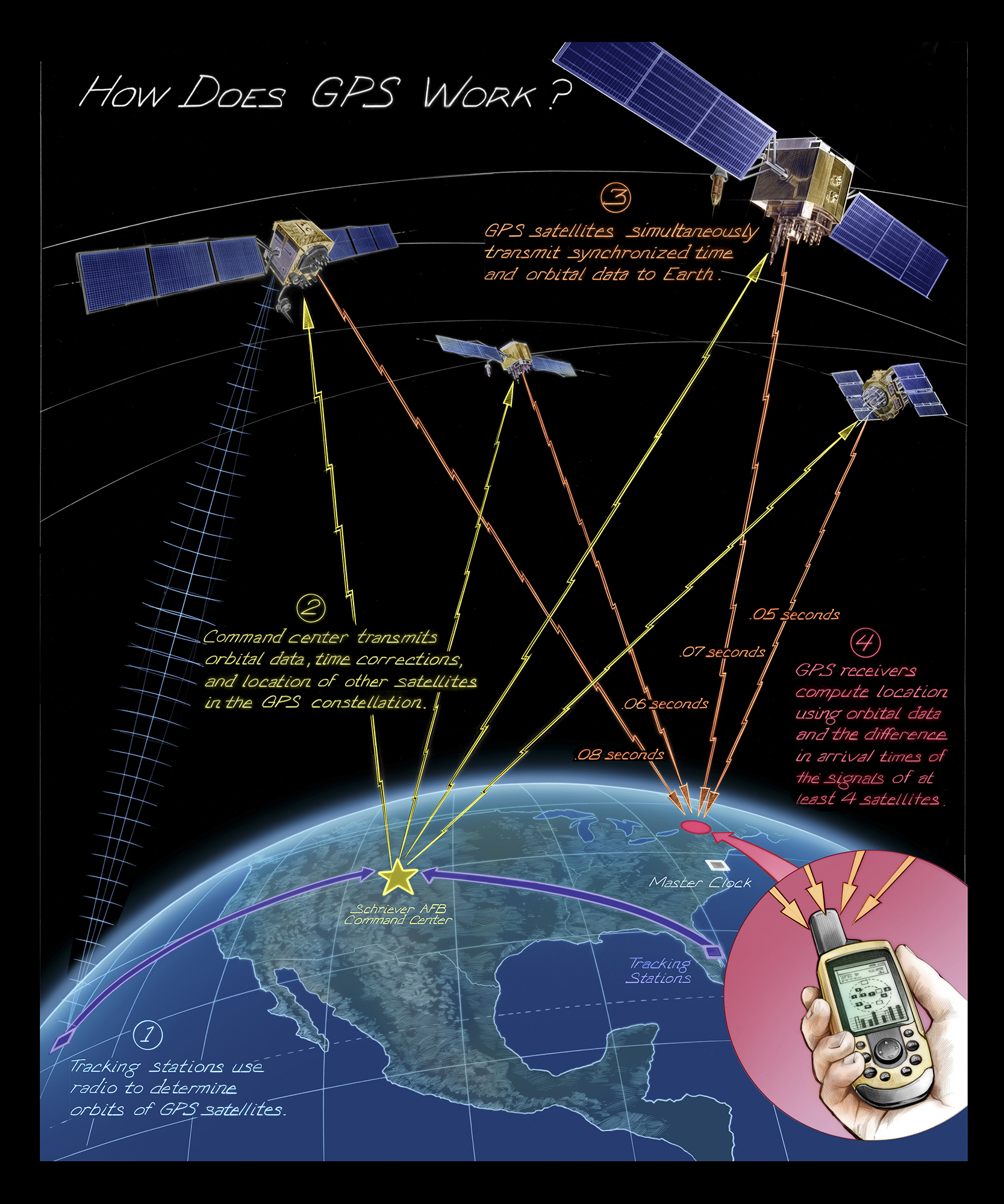

Ahora que el programa de control «sabe» que tiene que responder a mi intención sobre el clima, también sabe que tiene que conocer mi ubicación geográfica. Por suerte, existe una constelación de más de 24 satélites que orbitan la Tierra 2 veces por día a unos 20 mil km de altura a una velocidad de 14 mil km/h. Cada satélite lleva 4 relojes atómicos que utilizan las transiciones entre los diferentes niveles de energía de los electrones como si fuesen péndulos ultra precisos para medir el tiempo. Los satélites de GPS transmiten su medición del tiempo y un circuito electrónico en el teléfono, compara los tiempos recibidos de al menos 4 satélites y mediante cálculos matemáticos puede obtener la longitud y latitud en el planeta. Sin embargo, debido a que el tiempo de los relojes en los satélites transcurre más lento que el medido por un reloj en la superficie por causa de la velocidad relativamente alta de los satélites y que por otro lado, el tiempo transcurre más rápido que sobre la superficie debido al gradiente en el espacio-tiempo causado por la masa de la Tierra, es necesario que el sistema de GPS haga ajustes usando las teorías de Relatividad Especial y General de Einstein para poder tener mediciones de tiempo precisas.

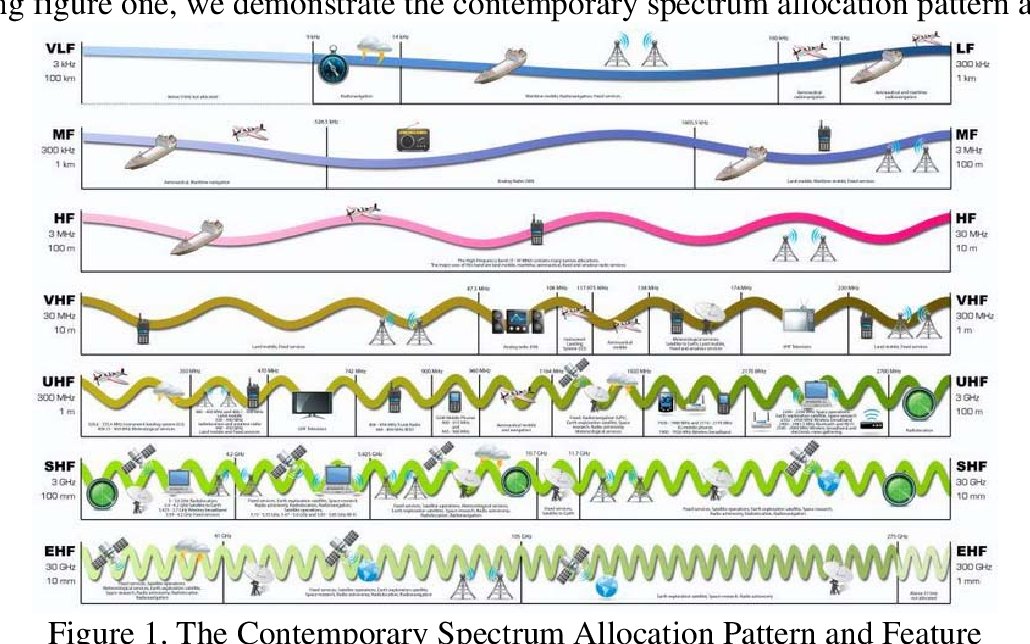

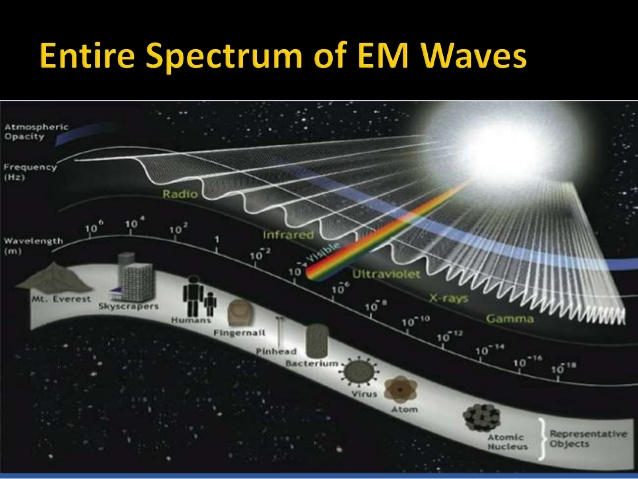

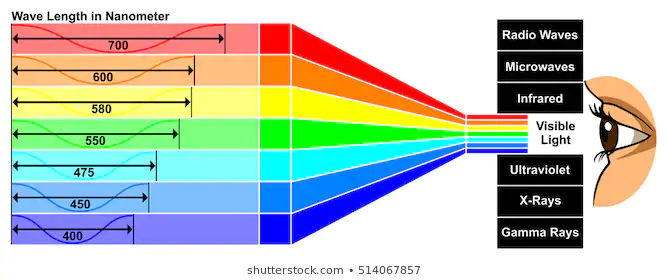

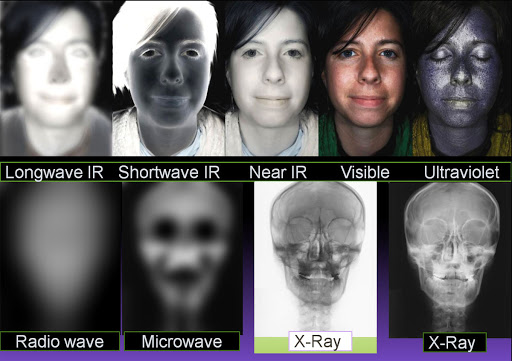

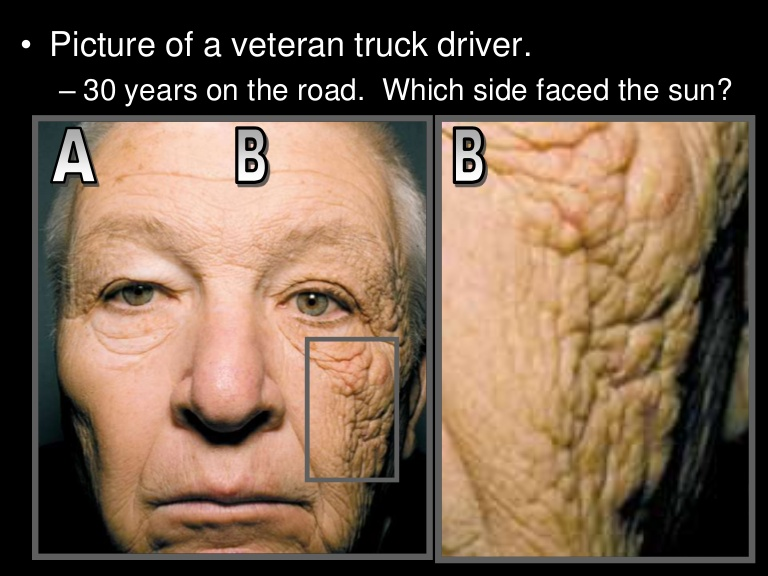

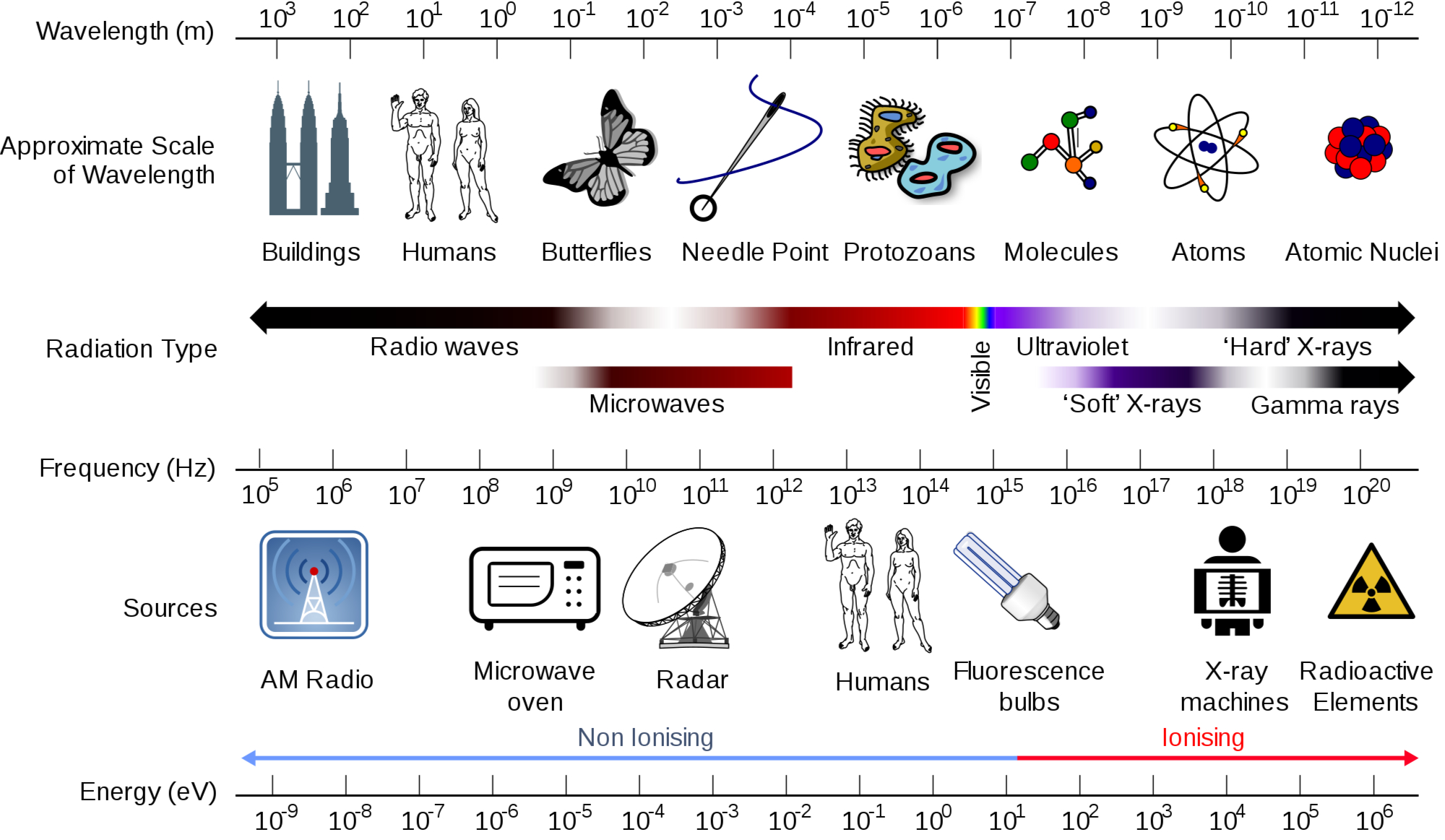

Las instrucciones del programa de control disparan una cascada de actividad en otros circuitos del celular, responsables por la interpretación de la cadena de bits que representa la señal eléctrica de las vibraciones captada por la membrana del micrófono para poder determinar la intención. Luego de complejos y repetitivos cálculos matemáticos determinados por diferentes algoritmos, se produce otra cadena de bits distinta que a su vez generan una señal eléctrica completamente diferente a la que fue producida originalmente por el micrófono. Esta nueva cadena de bits, pasa por otro circuito y otras instrucciones que la divide en paquetes, preparándolos para viajar. La señal eléctrica circula a través de una antena sacudiendo suavemente el campo electromagnético que permea todo el Universo. Estas imperceptibles vibraciones del campo electromagnético, completamente invisibles para los humanos, se repiten miles de millones de veces por segundo, propagándose a velocidad luz en todas direcciones. Esta agitación se suma y se mezcla con las provenientes de otras fuentes que interactúan con el campo electromagnético: otros dispositivos celulares, equipos de WiFi, radar, radios AM/FM, microondas, radar, satélites, GPS, TV, incluso el propio Sol.

A mil metros de distancia, la antena de una estación base, respondiendo a las oscilaciones del campo, comienza a ondular en sintonía con la señal irradiada por la antena de mi teléfono, ahora un millón de veces más tenue.

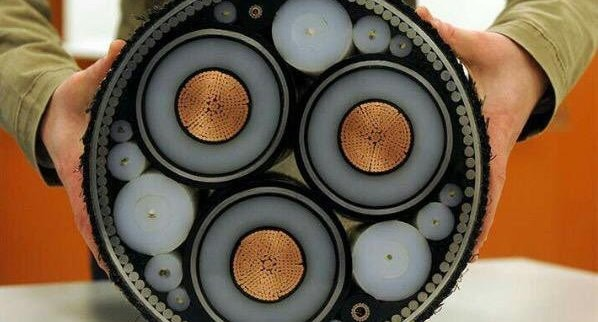

Las fluctuaciones captadas por la antena son convertidas en una corriente eléctrica que es amplificada y reconstruida, para luego extraer los bits que representan los paquetes que contienen la cadena de bits que contiene la codificación de la interpretación de la frase, para volver a re-empaquetarse en otro tipo de secuencia de bits que después terminan como pulsos de luz láser que viajan rebotando por las paredes de un tubo de vidrio flexible fino como un pelo humano, tal vez por decenas de kilómetros en su camino al corazón de la red móvil. En dicho trayecto, es posible que haya algunos saltos, donde la señal ahora óptica deba ser amplificada y regenerada varias veces para evitar que se degrade, sin contar con puntos donde estos y otros paquetes sean agregados para ser transportados por enlaces de mayor capacidad, equivalente a contenedores que pasan de camiones a inmensos barcos cargueros.

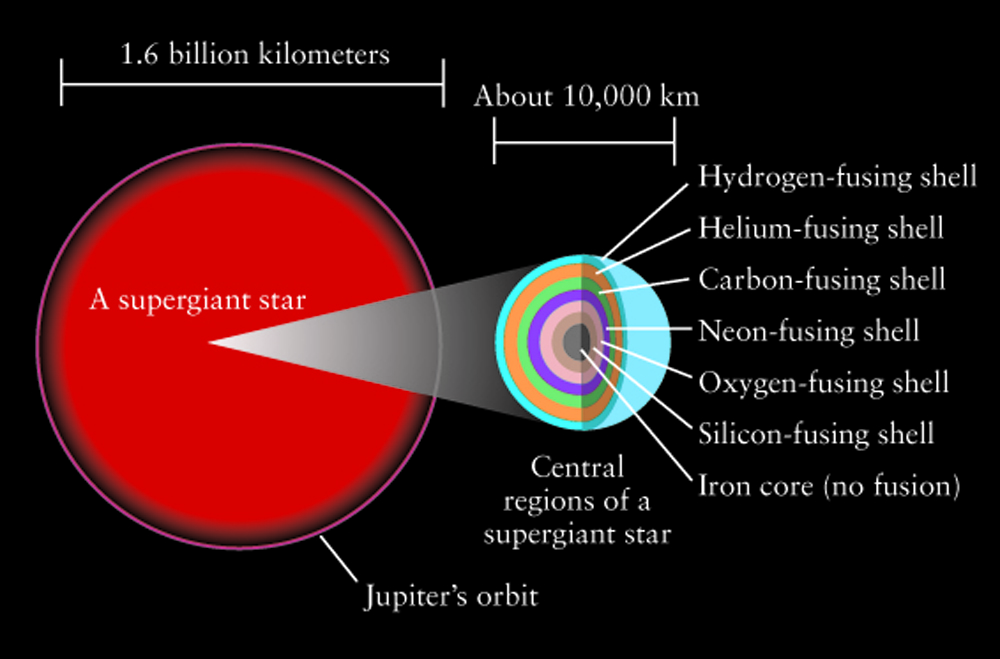

Eventualmente, los paquetes llegan a un equipo llamado ruteador que se encarga de encaminarlos según ciertas instrucciones, otras secuencias de bits, que vienen junto con los paquetes. Cada paquete es tratado de manera individual, de manera que la secuencia de bits que representa la intención de la frase recibida por el teléfono, a esta altura separada ya en varios paquetes, pueda ser que sea enviado por rutas distintas en su camino a la nube. Miles de millones de paquetes son enrutados por segundo. Solo algunos de esos paquetes corresponden a los enviados por mi teléfono. Durante este proceso, los pulsos de luz se convirtieron a pulsos eléctricos, que viajan por un circuito construido de un material semiconductor, típicamente fabricado de silicio, elemento químico que se encuentra en la arena y creado hace miles de millones de años durante los últimos días de vida de una estrella decenas de veces más masiva que nuestro Sol.

Los átomos de estos semiconductores están configurados en un entramado tridimensional y sus propiedades fueron alteradas por diseño para proveer exactamente las características necesarias para su funcionamiento.

Es posible, que haya varios ruteadores en el camino, probablemente de distintos fabricantes que se tuvieron que poner de acuerdo para que al menos en algunos puntos haya un funcionamiento estandarizado.

Eventualmente los paquetes se vuelven a convertir en pulsos de luz para hacer un viaje de miles de kilómetros a través de una fibra óptica submarina (hay más de 1 millón de km de cables submarinos en servicio, suficiente para dar más 300 vueltas al mundo), hasta que finalmente llegan a un gigantesco datacenter con cientos de miles de computadoras llamadas servidores donde convergen ya ordenados correctamente a un programa que está corriendo de manera distribuida en miles de nodos, los cuales a su vez son programas que simulan ser computadoras, de manera que la cantidad disponible de computadoras en el datacenter sea aún mayor.

Dentro de esa gigantesca muñeca Matrioshka, de capas de abstracción, sobre capas de abstracción de software, la cadena binaria que representa la intención obtenida del procesamiento de la codificación digital de los pulsos eléctricos captados por el micrófono de mi teléfono finalmente llega a destino. Como consecuencia, otros programas se disparan, generando a su vez una miríada de actividad en los circuitos electrónicos del servidor, equipos de comunicación, cables, fibras ópticas, equipos de almacenamiento de datos, etc. En algún momento, los valores necesarios para responder la pregunta inicial (ej: temperatura máxima, mínima, unidad de medida, etc.) son leídos de células de memoria de discos duros de estado sólido, en las que los electrones de sus átomos, mediante el efecto de túnel cuántico, han quedado atrapados de forma tal que seguirán “presos” aún cuando se corte la energía.

Ahora se inicia el proceso de retorno, donde los datos necesarios para responder la pregunta siguen un complejo y tortuoso camino similar, desde la nube al teléfono, durante el cual, campos eléctricos y magnéticos se manipulan en todo tipo de medios: semiconductores, conexiones de oro y platino, cables de cobre, coaxiales, fibras ópticas, ondas de radio, para producir el efecto deseado.

Pocos segundos después, la aplicación que inició toda el proceso recibe la respuesta y genera una señal eléctrica que mueve el diafragma del parlante del smartphone que a su vez mueve las moléculas de aire que lo rodean, generando una onda de presión que se propaga por el aire, hasta entrar a mi oído externo a través de un pasaje estrecho llamado “conducto auditivo” que llega hasta el tímpano.

El movimiento de las ondas sonoras hace que el tímpano vibre y a la vez transmita estas vibraciones a tres huesecillos diminutos del oído medio (llamados martillo, yunque y estribo). Los huesecillos del oído medio amplifican o aumentan las vibraciones de sonido y las envían a una estructura en forma de caracol llena de líquido (la cóclea), donde se forman ondas que viajan a lo largo de la membrana basilar. Las células ciliadas “bailan” con el movimiento de la ola. Al moverse hacia arriba y hacia abajo, unas proyecciones microscópicas parecidas a cerdas (conocidas como estereocilios), que se encuentran encima de las células ciliadas, se topan con una membrana sobresaliente y se inclinan. Esta inclinación hace que se abran unos canales que parecen poros, que están en las puntas de los estereocilios. Cuando esto sucede, ciertas sustancias químicas entran en las células, generando así una señal eléctrica. El nervio auditivo lleva esta señal eléctrica al cerebro, que la convierte en sonidos que podemos reconocer y entender: «Mañana en Asunción estará soleado con una máxima de 34° y una mínima de 21°».

1/ Vivimos en tiempos increíbles, hasta podría decirse que son mágicos, pero nos acostumbramos a que sea así y ya no nos damos cuenta.

🧵— Rolando Natalizia (@chonex) March 7, 2023

https://platform.twitter.com/widgets.js

En el 🧵que hice días atrás sobre la magia moderna que nos rodea, pero que pasa desapercibida, me olvidé agregar algunos detalles más que son también 🤯https://t.co/TCAq41b3NB

— Rolando Natalizia (@chonex) March 9, 2023

Hoy me llamaron de La Nación para preguntarme algunas cosas sobre el Apagón Analógico y me pareció un interesante tópico para escribir algunas ideas al respecto.

Hoy me llamaron de La Nación para preguntarme algunas cosas sobre el Apagón Analógico y me pareció un interesante tópico para escribir algunas ideas al respecto.

Un amigo me llamó a preguntar qué pensaba del Nexus 5. Le comenté que estaba por salir el Nexus 6 (code named «Shamu»), pero que lastimosamente todo indicaba a a que iba a ser un teléfono muy grande (cerca de 6″). Parece que «grande» es el tamaño de moda (a vos te hablo iPhone 6 Plus #cof, phablet, #cof).

Un amigo me llamó a preguntar qué pensaba del Nexus 5. Le comenté que estaba por salir el Nexus 6 (code named «Shamu»), pero que lastimosamente todo indicaba a a que iba a ser un teléfono muy grande (cerca de 6″). Parece que «grande» es el tamaño de moda (a vos te hablo iPhone 6 Plus #cof, phablet, #cof).